Хакерские группы, связанные с государственными структурами, используют Gemini от Google для сопровождения кибератак — от разведки до действий после взлома.

По данным Google, злоумышленники из Китая (APT31, Temp.HEX), Ирана (APT42), Северной Кореи (UNC2970) и России использовали Gemini для профилирования целей и сбора информации из открытых источников (OSINT), создания фишинговых приманок, перевода текстов, написания кода, тестирования уязвимостей и устранения технических проблем.

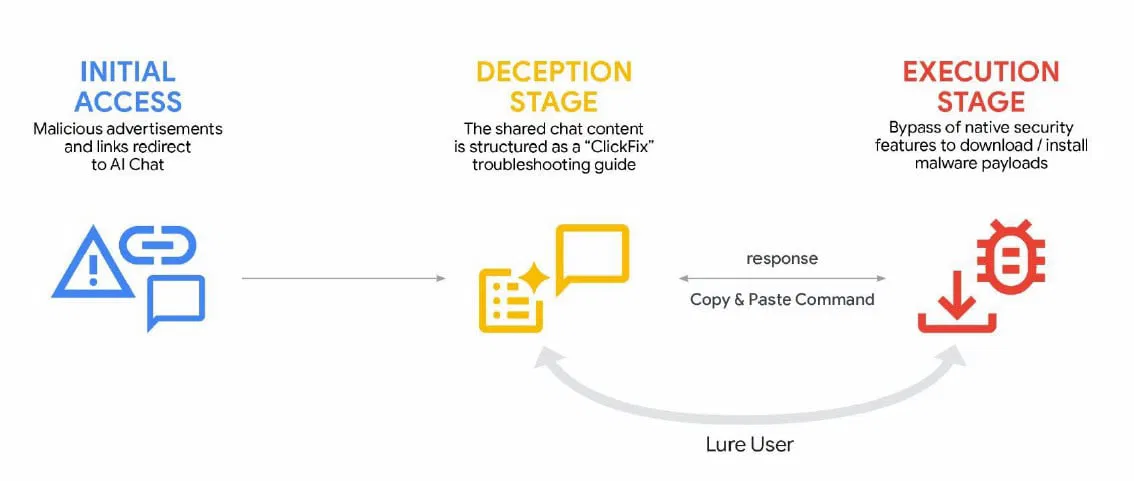

Киберпреступники в целом проявляют все больший интерес к ИИ-инструментам и сервисам, которые могут помочь в незаконной деятельности — например, в кампаниях социальной инженерии ClickFix.

ИИ как инструмент усиления атак

В новом отчете Google Threat Intelligence Group (GTIG) отмечается, что APT-группировки используют Gemini для поддержки своих операций «от этапа разведки и подготовки фишинговых писем до разработки инфраструктуры управления (C2) и эксфильтрации данных».

Китайские хакеры применяли «персону эксперта по кибербезопасности», чтобы просить модель автоматизировать анализ уязвимостей и составлять целевые планы тестирования в рамках вымышленного сценария.

Google сообщает:

Одна из группировок, связанный с КНР, моделировала ситуацию с использованием инструментария Hexstrike MCP и поручала модели анализировать удаленное выполнение кода (RCE), методы обхода WAF и результаты тестов на SQL-инъекции против конкретных целей в США.

Другой китайский злоумышленник регулярно задействовал Gemini для исправления кода, проведения исследований и получения рекомендаций по техническим возможностям вторжений.

Иранская группировка APT42 использовала LLM Google в кампаниях социальной инженерии, а также как платформу разработки для ускорения создания кастомизированных вредоносных инструментов — от генерации кода и отладки до изучения техник эксплуатации уязвимостей.

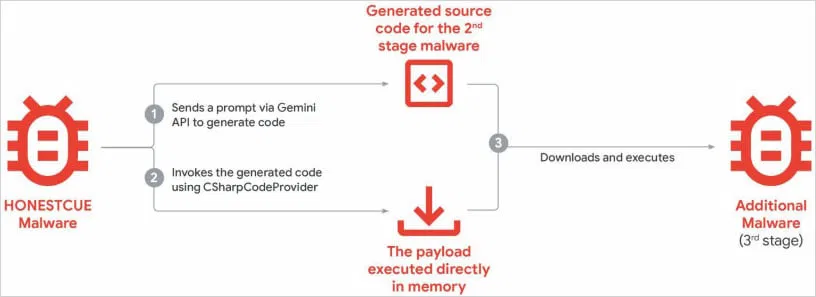

Google зафиксировал попытки внедрения новых возможностей в уже существующие семейства вредоносного ПО, включая фишинговый набор CoinBait и загрузчик/лаунчер HonestCue.

При этом GTIG подчеркивает: серьезных технологических прорывов в кибератаках пока не произошло. Однако ожидается, что операторы вредоносов продолжат интегрировать ИИ-возможности в свои инструменты.

HonestCue — это proof-of-concept-фреймворк вредоносного ПО, замеченный в конце 2025 года. Он использует API Gemini для генерации C#-кода второго этапа заражения, после чего компилирует и выполняет полезную нагрузку прямо в памяти.

CoinBait — это фишинговый комплект, замаскированный под криптовалютную биржу. Он реализован как React-приложение (SPA) и предназначен для кражи учетных данных.

В коде обнаружены артефакты, указывающие на использование ИИ-инструментов для генерации кода. В частности, в исходниках присутствовали лог-сообщения с префиксом «Analytics:», что может помогать отслеживать процессы эксфильтрации данных.

По мнению исследователей GTIG, вредонос был создан с применением платформы Lovable AI — разработчик использовал Lovable Supabase client и сервис lovable.app.

Киберпреступники также применяли генеративные ИИ-сервисы в кампаниях ClickFix, распространяя инфостилер AMOS для macOS. Пользователей заманивали через вредоносные рекламные объявления в поисковой выдаче по запросам, связанным с устранением технических проблем. Жертв убеждали вручную выполнить вредоносные команды.

В отчете отмечается, что Gemini подвергалась попыткам извлечения и дистилляции модели. Злоумышленники с легальным API-доступом систематически отправляли запросы, чтобы воспроизвести логику принятия решений модели и фактически клонировать ее функциональность.

Хотя это не несет прямой угрозы пользователям или их данным, проблема представляет серьезный коммерческий и интеллектуальный риск для разработчиков ИИ-моделей.

Суть схемы — перенос знаний из одной модели в другую с использованием техники машинного обучения «дистилляция знаний», позволяющей обучать новые модели на основе более продвинутых.

Исследователи GTIG сообщают:

Извлечение модели и последующая дистилляция знаний позволяют атакующему значительно ускорить разработку собственной ИИ-модели при существенно меньших затратах.

Google рассматривает такие атаки как масштабируемую форму интеллектуального хищения, которая может подорвать бизнес-модель AI-as-a-Service и в перспективе повлиять на конечных пользователей.

В рамках одной крупной атаки против Gemini было отправлено около 100 000 запросов, направленных на воспроизведение логики модели при выполнении задач на языках, отличных от английского.

Google уже заблокировал аккаунты и инфраструктуру, связанные с выявленными злоупотреблениями, а также внедрил дополнительные защитные механизмы в классификаторы Gemini для усложнения подобных атак.

Компания заявляет, что проектирует ИИ-системы с применением надежных мер безопасности и строгих ограничений, а также регулярно тестирует модели для повышения их устойчивости и защищенности.

Угрозы безопасности

• Google: хакеры используют Gemini AI на всех этапах кибератак

• Фальшивый сайт 7-Zip распространяет ПО для скрытого создания прокси-сетей

• Атаки ShadyPanda и GhostPoster: как миллионы пользователей пострадали от обновлений легитимных расширений

• «Доктор Веб» рассказал, как противостоять мошенническим звонкам

• В игре People Playground через Steam Workshop распространялся вредоносный мод

• Разработчики Notepad++ подтвердили взлом серверов обновлений