Китайский стартап DeepSeek объявил о масштабном обновлении своей линейки ИИ-продуктов, представив две новые большие языковые модели: DeepSeek-V3.2 и DeepSeek-V3.2-Speciale. Обе разработки находятся в открытом доступе, что позволяет сообществу разработчиков свободно изучать и использовать их архитектуру.

Базовая версия V3.2 позиционируется как стабильное решение для повседневных задач. По заявлению создателей, скорость работы и качество ответов этой нейросети сопоставимы с показателями GPT-5 Thinking. Важным преимуществом стала экономическая эффективность: стоимость использования модели через API в 24 раза ниже по сравнению с аналогами.

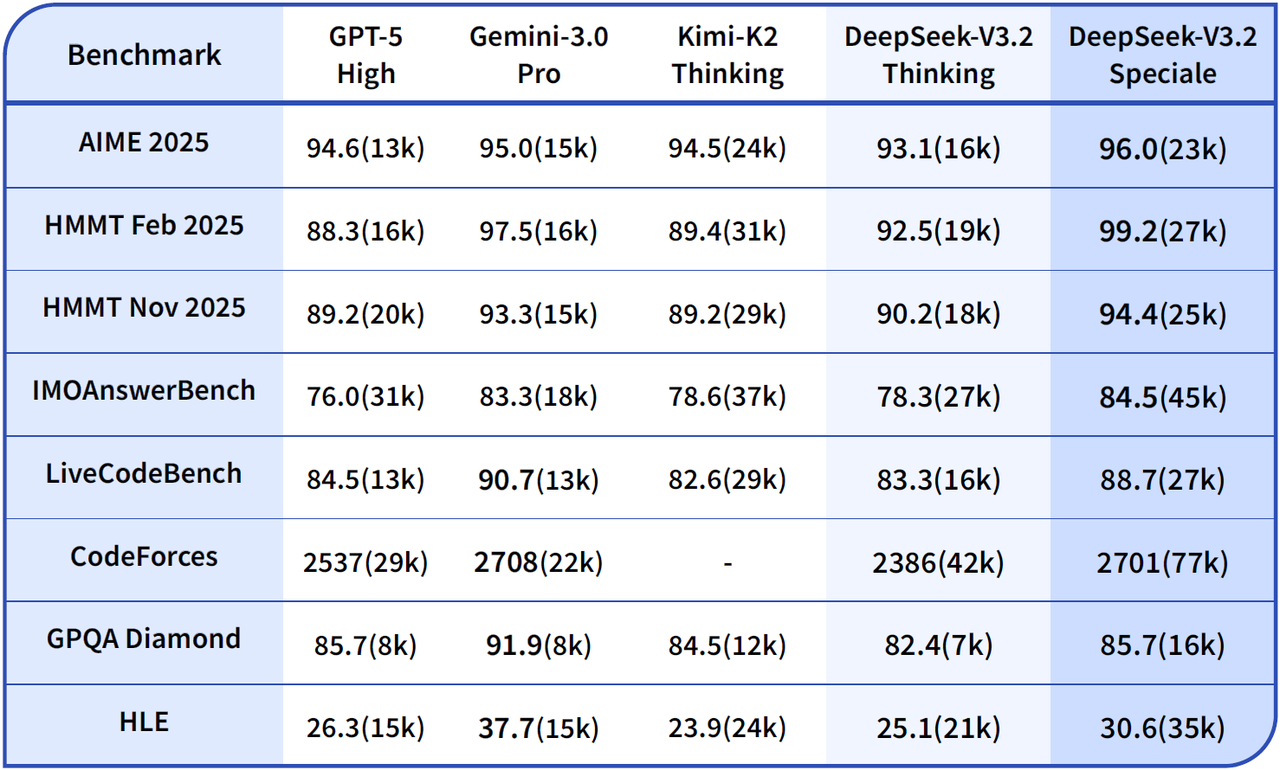

Вторая модель, DeepSeek-V3.2-Speciale, ориентирована на решение задач повышенной сложности. Она стала первым широкодоступным инструментом, показавшим результаты уровня золотой медали на международных математических олимпиадах и финале чемпионата мира по программированию. В тестах AIME и HMMT нейросеть демонстрирует высокую точность математических вычислений, а в бенчмарке GPQA Diamond подтверждает глубокие знания в физике, химии и биологии.

Технические особенности и архитектура

В техническом отчете компания раскрыла три ключевых фактора, позволивших достичь таких показателей производительности.

Первый фактор - технология DeepSeek Sparse Attention. Инженеры отказались от анализа всех 128 тысяч токенов контекста на каждом шаге генерации. Вместо этого архитектура выбирает 2048 наиболее релевантных элементов с помощью специального легкого блока - «молниеносного индексатора». Это решение снизило вычислительную сложность с квадратичной до почти линейной, что существенно удешевило инференс на длинных контекстах. Эффективность подхода подтверждается данными с вычислительных кластеров H800.

Второй фактор - агрессивное пост-обучение. Бюджет на обучение с подкреплением (RL) превысил 10% от стоимости предварительного обучения. Процесс включает тренировку отдельных «специалистов» в областях математики, программирования и логики, чьи знания затем дистиллируются в единую модель. Для стабильности масштабирования применяются сложные методы, такие как исправление смещения в KL-штрафе и фиксация маршрутизации экспертов.

Третий фактор - работа с данными для автономных агентов. Обучающая выборка включает более 1800 интерактивных сред, включая поисковые системы и репозитории кода. В отличие от предыдущих версий, V3.2 умеет сохранять цепочку рассуждений между вызовами инструментов, обнуляя контекст только при новом запросе пользователя. Это повышает удобство использования и экономит ресурсы в сложных сценариях.

Ограничения и доступность

Разработчики отмечают и недостатки новой архитектуры. Из-за сокращенного этапа предварительного обучения модели обладают меньшим объемом энциклопедических знаний по сравнению с конкурентами. Кроме того, глубокое рассуждение требует значительных ресурсов: для достижения качества ответов уровня Gemini 3 Pro версия Speciale расходует больше токенов. Например, в тесте AIME 2025 модели от Google требуется 15 тысяч токенов, тогда как решению от DeepSeek - около 23 тысяч.

Модель DeepSeek-V3.2 уже доступна пользователям через веб-интерфейс и мобильные приложения, работающие в РФ без ограничений, а также через API. Версия Speciale на данный момент распространяется только посредством API-интерфейса.

Обновления программ, что нового

• Anthropic представила новую модель Claude Opus 4.6 с контекстом до 1 млн токенов

• Передача файлов через AirDrop станет доступна на любых Android-смартфонах

• В Firefox Beta появился переключатель для полного отключения ИИ-функций

• YouTube открыл автоматический ИИ-дубляж для всех: 27 языков и поддержка русского

• Яндекс запустил обучение школьников ИИ-робототехнике — онлайн и в очных кружках Яндекс Лицея

• Смартфоны Samsung серии Galaxy S21 получили последние обновления безопасности – поддержка завершена